Ricerca: non si vive di sole citazioni

La ricerca scientifica va valutata. Ma come? Un'analisi critica del metodo Civr, basato sull'impact factor. E una proposta di correzione

L’esercizio di valutazione 2001-2003, promosso dal Comitato di Indirizzo della Valutazione della Ricerca (CIVR), è certamente un episodio positivo e da ripetere, anche se, a nostro parere, ci sono due problemi nella procedura di valutazione utilizzata: l’idea che la valutazione scientifica di un ateneo sia espressa semplicemente dalle pubblicazioni del suo organico, e il fatto che i referee abbiano utilizzato, come criterio di valutazione, il prestigio delle pubblicazioni.1 Il problema del riferimento al “prestigio” di una rivista è che questo viene generalmente valutato sulla base di indici bibliometrici (come l’Impact Factor) basati sul numero medio di citazioni ricevute dagli articoli pubblicati nella rivista stessa.

Per i prodotti considerati dal Panel 13 del Civr, abbiamo paragonato gli Impact Factor (delle riviste) con il numero di citazioni (dei prodotti) registrate dal motore di ricerca Google Scholar.

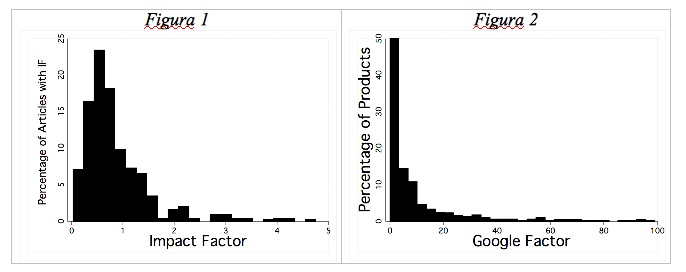

La prima osservazione riguarda la composizione del campione: generalmente, le citazioni di diversi prodotti hanno una forma esponenziale, come nella Figura 2 (che rappresenta le citazioni su Google Scholar), in quanto poche pubblicazioni sono molto citate (a sinistra), e molte pubblicazioni sono poco citate (a destra).

Come si nota dalla Figura 1, l’Impact Factor dei prodotti presentati al Civr ha una distribuzione diversa, con una media spostata più a destra (ovvero verso valori più alti). Questa distribuzione dimostra che le università oggetto di valutazione hanno effettivamente tentato di far valutare prodotti con Impact Factor mediamente alto.

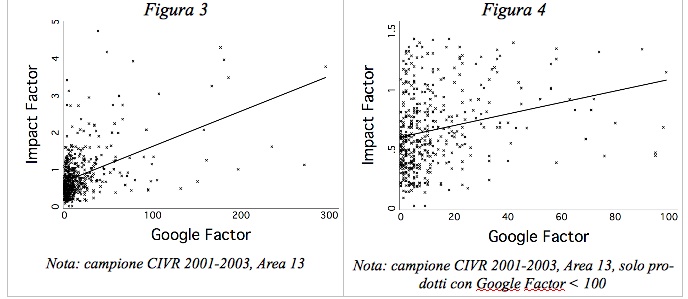

La seconda osservazione che possiamo fare è la scarsa correlazione dell’Impact Factor delle riviste con le citazioni dei singoli prodotti, mostrata nella Figura 3 (e in dettaglio nella Figura 4, che presenta uno zoom della parte in basso a sinistra della Figura 3). In altre parole, poiché l’Impact Factor misura solo il numero di citazioni medie degli articoli in una certa rivista, una valutazione del singolo prodotto sulla base di questo indice non tiene conto della forte variabilità tra gli articoli di una stessa rivista.

Dunque, una valutazione dei singoli prodotti operata sulla base del prestigio delle riviste in cui sono pubblicati rischia di condurre 1) a una valutazione possibilmente errata, come si evince dalla forte dispersione delle citazioni dei singoli articoli, a parità di Impact Factor delle riviste; 2) ad una distorsione della ricerca in favore del solo obiettivo di pubblicare sulle riviste a maggiore Impact Factor, invece che di produrre pubblicazioni di qualità, come emerge dalla selezione dei lavori presentati per la valutazione.

Questo secondo aspetto è, purtroppo, spesso trascurato dal dibattito. Valutando alcuni prodotti come migliori di altri, e ancor più orientando il finanziamento della ricerca sulla base della valutazione, si creano forti incentivi per i ricercatori a occuparsi di alcuni temi o a coltivare determinati paradigmi di ricerca: insomma la valutazione della ricerca influenza la direzione della ricerca stessa.

Tale osservazione è particolarmente rilevante alla luce dell’esistenza di differenze sistematiche nel numero di citazioni che ricevono i prodotti di discipline diverse, o di aree diverse di una stessa disciplina. Queste differenze possono essere dovute a diversi fattori: la numerosità dei ricercatori che si occupano di un certo argomento, gli usi più o meno estensivi di citare, l’esistenza di “networks di citazioni”, il numero di autori, l’utilizzo interno o esterno dell’articolo (ad esempio, un articolo che introduce una nuova metodologia è generalmente più citato di quelli che la applicano).2

Un esempio estremo è il paragone tra la fisica e l’economia: le riviste di fisica non raramente hanno Impact Factor sette-otto volte più grandi di quelle economiche, ma non per questo vorremmo sostenere che un buon fisico è otto volte più bravo dei migliori economisti. Inoltre, non è semplice capire in che senso “più bravo”, dal momento che confrontiamo cose diverse. Idealmente, ogni scienziato va valutato con riferimento alla propria disciplina, mentre la comparazione dell’importanza relativa delle discipline non può che essere una scelta politica.

In piccolo, questo argomento vale anche per le diverse discipline dell’economia: è difficile infatti confrontare campi così diversi come la finanza e la storia economica, o la politica economica e l’economia aziendale. Per questo motivo, proponiamo che le valutazioni, sia quantitative sia qualitative, siano operate con riferimento al settore scientifico-disciplinare dei singoli prodotti. Come è stato notato, il rischio di tale procedura è l’emergere di “riserve dei panda” e sacche di inefficienza, qualora alcuni gruppi di scienziati riuscissero a sottrarsi a una rigorosa valutazione ritagliandosi un settore a se stante, ipoteticamente caratterizzato da standard scientifici più bassi. A nostro parere, questo rischio non può che essere corretto dalla politica della ricerca, anziché scaricato sulla valutazione, in quanto questa seconda soluzione attribuisce troppi obiettivi a un solo strumento (la valutazione) e in quanto occorre evitare il ben noto rischio di indurre gli scienziati al conformismo e allo studio di pochi, specifici temi.

1 Testimonianza di questo è fornita dalla stessa Relazione Finale del panel 13, disponibile all’indirizzo http://civr.cineca.it

2 Una interessante rassegna di lavori sui networks di economisti è fornita da Baccini e Barabesi (2009), “Interlocking Editorship. A Network Analysis of the Links between Economic Journals”, su Scientometrics.

La riproduzione di questo articolo è autorizzata a condizione che sia citata la fonte: old.sbilanciamoci.info.

Vuoi contribuire a sbilanciamoci.info? Clicca qui